Al febrer del 2019, OpenAI, un dels laboratoris d’intel·ligència artificial més importants del món, va anunciar que un equip d’investigadors havia construït un poderós generador de text anomenat Generative Pre-Trained Transformer 2 o GPT-2.

|

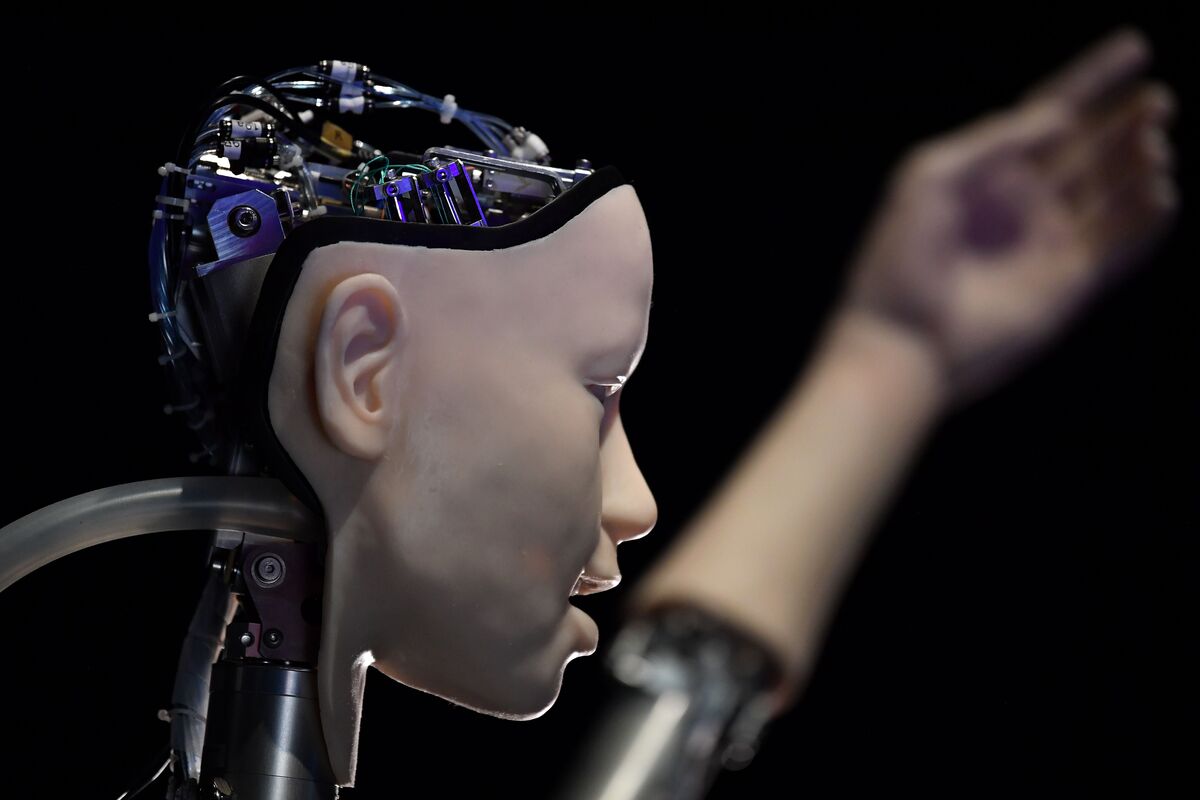

| Font: Flipboard |

Però, com passa sovint amb la tecnologia NLP, aquesta eina va suposar una gran promesa i un gran perill. Els investigadors i els responsables polítics del laboratori estaven preocupats perquè el seu sistema, pogués ser explotat per hackers i apropiar-se amb “propòsits maliciosos”.

Des d'OpenAI, es defineix la seva missió com "descobrir i promoure el camí cap a la intel·ligència general segura artificial", es preocupen que GPT-2 es pugui utilitzar des d'Internet amb fals text, degradant així un ecosistema d'informació ja fràgil. Per aquest motiu, OpenAI va decidir que no llançaria la versió completa del GPT-2 al públic ni a altres investigadors.

GPT-2 és un exemple d'una tècnica basada en PNL anomenada modelatge de llenguatge, mitjançant la qual el sistema computacional interioritza un model estadístic d'un text per tal de poder-lo imitar.

|

| Font: HP Store |

De la mateixa manera que el text predictiu del telèfon, que selecciona paraules basades en paraules que s'havíen utilitzat abans, GPT-2 pot mirar una cadena de text i, a continuació, predir quina és la probabilitat de la següent paraula en funció de les probabilitats inherents a aquest text.

GPT-2 es pot veure com un descendent del model estadístic del llenguatge que el matemàtic rus AA Markov va desenvolupar a principis del segle XX.

GPT-2, va utilitzar algoritmes d’aprenentatge automàtic d’avantguarda per fer anàlisis lingüístiques amb més d’1,5 milions de paràmetres.

Tanmateix, la diferència amb GPT-2 és l'escala de les dades textuals modelades pel sistema. Mentre que Markov va analitzar una cadena de 20.000 cartes per crear un model rudimentari que pogués predir la probabilitat que la següent carta d’un text fos una consonant o una vocal, GPT-2 va utilitzar dins del conjunt de dades complet, 8 milions d’articles raspats de Reddit per predir quina podria ser la següent paraula.

I mentre que Markov va entrenar manualment el seu model comptant només dos paràmetres, vocals i consonants, GPT-2 va utilitzar algoritmes d’aprenentatge de màquines d’avantguarda per fer anàlisis lingüístiques amb més d’1,5 milions de paràmetres, creant una quantitat enorme de potència computacional en el procés.

Els resultats van ser impressionants. OpenAI va informar que GPT-2 podia generar text sintètic en resposta a les indicacions, imitant qualsevol estil de text que es mostrés. Si se li demana al sistema amb una línia de poesia de William Blake, pot generar una línia a l'estil del poeta romàntic. Si es sol·licita al sistema amb una recepta de pastissos, s'obtindrà una resposta d'una recepeta recent.

|

| Font: IEEE Spectrum |

Potser la característica més convincents de GPT-2, és que pot respondre preguntes amb precisió. Per exemple, quan els investigadors de l'OpenAI van preguntar al sistema, "Qui va escriure el llibre L'origen de les espècies? ”—Va respondre:« Charles Darwin ». Tot i que només és capaç de respondre amb precisió en un periode temporal petit, la característica sembla ser una realització limitada del somni de Gottfried Leibniz de fer una màquina generadora de llenguatge que pogués respondre a totes les preguntes humanes.

Després d’observar la potència del nou sistema a la pràctica, OpenAI va optar per no llançar el model completament format. Com a conseqüència del seu llançament al febrer, hi ha hagut una consciència més gran sobre “ deepfakes ”: imatges i vídeos sintètics, generats mitjançant tècniques d’aprenentatge automàtic, en què les persones fan i diuen coses que no han fet ni deien. Els investigadors d'OpenAI van preocupar-se que la GPT-2 es pogués utilitzar bàsicament per crear text, cosa que ho dificulta per la gent que confia en informació textual en línia.

Les respostes a aquesta decisió van variar. D’una banda, la prudència d’OpenAI va provocar una reacció desbordada als mitjans de comunicació, amb articles sobre els "perills" de la tecnologia que s’incorpora a la narració de Frankenstein que sovint envolta els desenvolupaments de la IA.

Altres van posar en dubte l’autopromoció d’OpenAI, alguns fins i tot van suggerir que OpenAI va exagerar de manera intencionada sobre la potencia del GPT-2 per crear hype, mentre que contravenien una norma a la comunitat de recerca d’AI, on els laboratoris comparteixen rutinàriament dades, codi i models pre-entrenats.

| ||

| Brockman i Ilya Sutskever d'OpenAI. Font: GluekitGreg |

Imitant els humans de Reddit, els robots mantenen llargues converses sobre diversos temes, com ara teories de conspiracions i pel·lícules de la Guerra de les Galeries.

Aquesta conversa basada en bot pot significar la nova condició de vida on-line, on el llenguatge està cada cop és més una combinació d’agents humans i no humans, de manera que, mantenir la distinció entre humans i no humans, malgrat els millors esforços, és cada cop més difícil. .

La idea d’utilitzar regles, mecanismes i algorismes per generar llenguatge, ha inspirat a les persones de moltes cultures diferents al llarg de la història. Però és en el món on-line que aquesta poderosa forma de wordcraft pot trobar realment el seu entorn natural: en un entorn on la identitat dels parlants es fa més ambigua i, potser, menys rellevant. Cal veure quines seran les conseqüències per al llenguatge, la comunicació i el nostre sentit d’identitat humana, tan lligat amb la nostra capacitat de parlar en un llenguatge natural.

Font: IEEE Spectrum

Cap comentari:

Publica un comentari a l'entrada