Com es podria ensenyar als vehicles de conducció autònoma per adquirir una més profunda consciència del món que els envolta? Els ordinadors poden aprendre d’experiències passades per reconèixer patrons futurs que els poden ajudar a navegar de forma segura en situacions noves i imprevisibles?

Aquestes són algunes de les preguntes que els investigadors del AgeLab del MIT Center for Transport and Logistics i el Toyota Collaborative Safety Research Center (CSRC) estan tractant de respondre compartint una innovadora base de dades oberta anomenat DriveSeg.

|

| Font: Li Ding, Jack Terwilliger. |

Mitjançant el llançament de DriveSeg, el MIT i Toyota treballen per avançar en la investigació en sistemes de conducció autònoma que, de la mateixa manera que la percepció humana percep l’entorn de conducció com un flux continu d’informació visual.

Al compartir aquest conjunt de dades, s'espera motivar als investigadors, la indústria i altres innovadors a desenvolupar una nova visió i orientació en el modelat temporal de la IA que permeti la propera generació de les tecnologies per la conducció assistida i la seguretat automobilística.

La potencia predictiva, és una part important de la intel·ligència humana, sempre que es condueix, sempre es realitza seguiment dels moviments de l'entorn per identificar potencials riscos i prendre decisions més segures. En compartir aquest conjunt de dades, s'espera accelerar la investigació sobre sistemes de conducció autònoms i les avançades funcions de seguretat més adaptades a la complexitat de l’entorn que ho envolta.

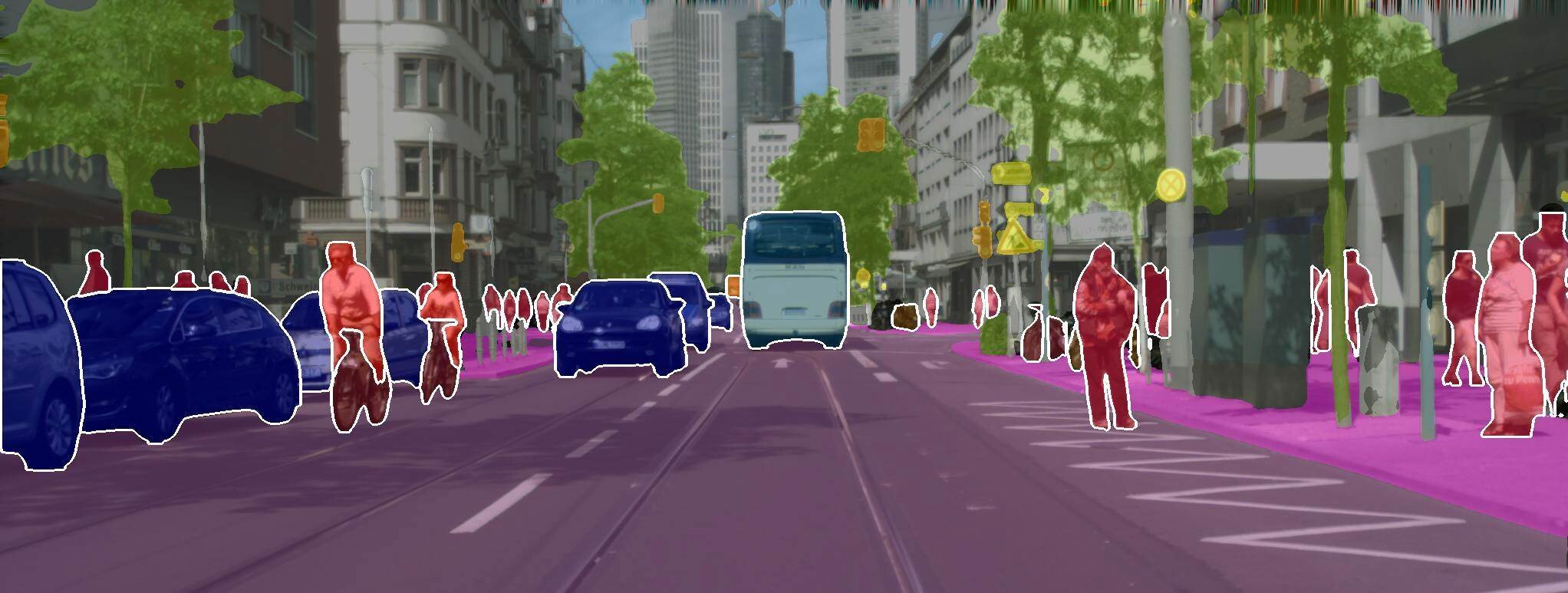

Fins a la data, les dades d’auto-conducció posades a la disposició de la comunitat investigadora han consistit principalment en la cerca d’imatges individuals i estàtiques que es podien utilitzar per identificar i fer un seguiment dels objectes comuns que es troben per la carretera i al seu voltant, com són les bicicletes, els vianants o els semàfors, mitjançant l’ús de “caixes que els encerclen dins dels seus llindars. Per contra, DriveSeg conté representacions més precises de molts d’aquests mateixos objectes de ruta comuns a nivell de píxel, però a través d'una òptica mitjançant una lent de vídeo en continu que s'usa per la conducció. Aquest tipus d'escena complerta i segmentació pot ser especialment útil per identificar objectes més amorfs, com ara la construcció de carreteres i la vegetació, que no sempre tenen formes tan definides i uniformes.

La percepció duna escena de conducció basada en vídeo, proporciona un flux de dades que s’assemblen més a les situacions dinàmiques de la conducció en un món real. També permet als investigadors explorar els patrons de dades a mesura que es reprodueixen durant el pas del temps, cosa que podria portar nous avenços en l'aprenentatge de màquines, comprensió d'escenes i predicció del comportament.

|

| Font: Li Ding, Jack Terwilliger. |

DriveSeg està disponible de forma gratuïta i pot ser utilitzat per investigadors i la comunitat acadèmica amb finalitats no comercials. Les dades es componen de dues parts. El DriveSeg (manual) és un vídeo de 2 minuts i 47 segons d'alta resolució capturat en el decurs d'un viatge durant el dia pels carrers molt transitats de Cambridge, Massachusetts. Els 5.000 fotogrames del vídeo s'anoten densament de forma manual amb etiquetes humanes per píxel de 12 classes d'objectes de les carreteres.

DriveSeg (Semi-Auto) són 20.100 fotogrames de vídeo (67 clips de vídeo de 10 segons) extretes a partir de les dades del consorci MIT Advanced Vehicle Technologies (AVT). DriveSeg (Semi-auto) està etiquetat amb la mateixa anotació semàntica en píxels que ve en el DriveSeg (manual), tret que les anotacions es completessin mitjançant un nou enfocament d'anotació semiautomàtica desenvolupat per MIT. Aquest enfocament empra els esforços tant manuals com computacionals per anotar les dades de manera més eficient amb un cost inferior a l’anotació manual. Aquest conjunt de dades es va crear per avaluar la viabilitat d’anotar una àmplia gamma d’escenaris de conducció del món real i valorar el potencial dels sistemes de percepció de vehicles d’entrenament en etiquetes de píxels creades mitjançant sistemes d’etiquetatge basats en AI.

Font: AgeLab del MIT Center for Transport and Logistics i el Toyota Collaborative Safety Research Center

Cap comentari:

Publica un comentari a l'entrada