Aquest nou programari de seguiment del cos humà, podria ajudar als robots a llegir les emocions.

Si un amic diu que se sent relaxat, però es pot veure que els seus punys estan tancat, potser es dubte de la seva sinceritat. Els robots, en canvi, podrien tenir el seu criteri. El llenguatge corporal diu molt, però fins i tot amb avenços en la tecnologia de la visió per ordinador i el reconeixement facial, els robots lluiten per notar un moviment subtil del cos i per això poden perdre indicis socials importants.

|

| Font: IEEE Spectrum |

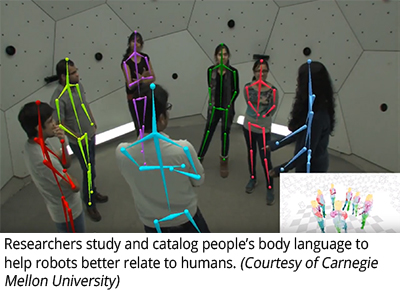

Investigadors de la Universitat Carnegie Mellon van desenvolupar un sistema de seguiment del cos que podria ajudar a resoldre aquest problema. Anomenat OpenPose , el sistema pot fer un seguiment del moviment del cos, incloses les mans i la cara, en temps real. Utilitza visió per ordinador i aprenentatge automàtic per processar fotogrames de vídeo, i fins i tot pot fer un seguiment de diverses persones simultàniament. Aquesta capacitat pot facilitar les interaccions entre els humans i els robots i obrir el camí cap a una realitat augmentada virtual i interactiva i intuïtiva.

Una característica destacable del sistema OpenPose és que pot rastrejar no només el cap, el tors i les extremitats d’una persona, sinó també els dits per separat. Per fer-ho, els investigadors van utilitzar el Panoptic Studio de la CMU , una cúpula revestida de 500 càmeres, on van capturar les posicions del cos en diversos angles i després van utilitzar aquestes imatges per construir un conjunt de dades.

|

| Font: Seminar Topics |

A continuació, van passar aquestes imatges a través del que s’anomena detector de punts clau per identificar parts específiques del cos. El programari també aprèn a associar les parts del cos amb els individus, per la qual cosa sap, per exemple, que la mà d’una persona sempre estarà a prop del colze. Això permet fer un seguiment de diverses persones alhora.

Les imatges de la cúpula van ser capturades en 2D. Però els investigadors van prendre els punts clau detectats i els van triangular en 3D per ajudar els algoritmes de seguiment del seu cos a comprendre com apareix cada proposta des de perspectives diferents. Amb totes aquestes dades processades, el sistema pot determinar com es veu tota la mà quan es troba en una posició determinada, fins i tot si alguns dits estan amagats.

|

| Font: CMU Robotics Institute |

Diuen que aquesta tecnologia es podria aplicar a tot tipus d'interaccions entre humans i màquines. Podria tenir un paper important en les experiències de VR, permetent la detecció més fina del moviment físic de l'usuari sense cap tipus de maquinari addicional, com ara sensors o guants .

També podria facilitar interaccions més naturals amb un robot casolà. Es podria dir al robot que "reculli" el que s'assenyali i aquest, ho podria entendre de seguida. En percebre i interpretar els gestos físics, el robot fins i tot pot aprendre a llegir emocions fent un seguiment del llenguatge corporal.

Font: Universitat Carnegie Mellon

Cap comentari:

Publica un comentari a l'entrada