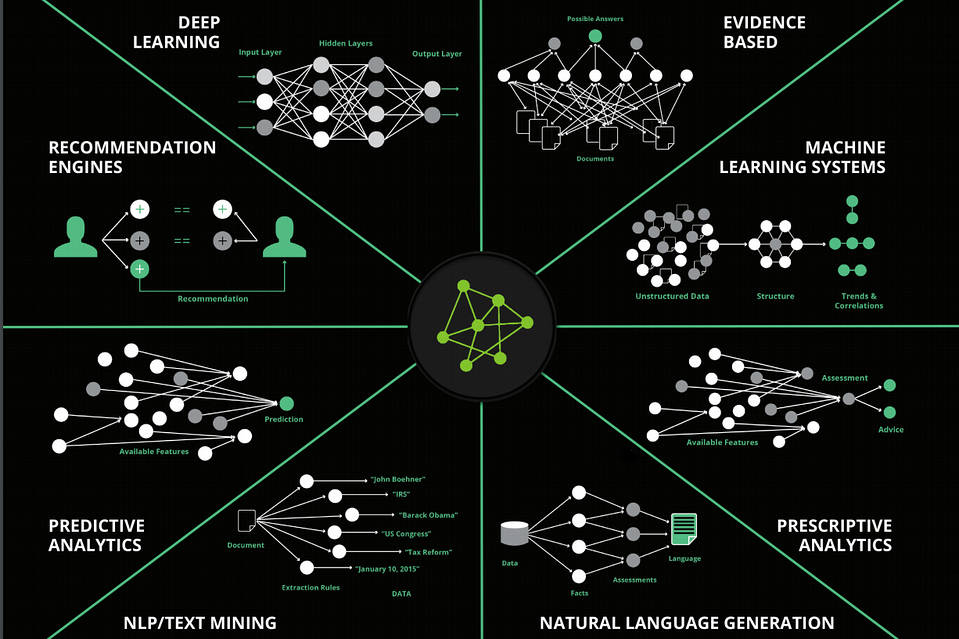

Darrere de la majoria de les tecnologies actuals d'intel·ligència artificial que s'apliquen, des d'automòbils auto-controlats fins al reconeixement facial passant pels auxiliars virtuals, estan formats per xarxes neuronals artificials. Encara que es basen en el funcionament de les neurones del cervell, aquests sistemes de deep learning segueixen sent incapaços de fer moltes funcions bàsiques que són essencials per als primats i altres organismes.

Tanmateix, un nou estudi dels neuro-científics de la Universitat de Chicago, van trobar que l'adaptació d'un conegut mecanisme cerebral, pot millorar la capacitat de les xarxes neuronals artificials per aprendre múltiples tasques i resoldre el repte de la Intel·ligència Artificial (AI) conegut com "oblit catastròfic". L'estudi, publicat a l'acadèmia Nacional de Ciències, proporciona un exemple únic de com la investigació sobre neuro-ciències pot aportar a les noves estratègies informàtiques i, al contrari, com la tecnologia AI pot ajudar els científics a comprendre millor el cervell humà.

En xarxes neuronals artificials, l'oblit catastròfic es refereix a la dificultat d'ensenyar el sistema a realitzar noves habilitats sense perdre funcions prèviament apreses. Per exemple, si una xarxa inicialment entrenada per distingir entre fotografies de gossos i gats es torna a entrenar per distingir entre gossos i cavalls, perdrà la seva capacitat anterior.

En xarxes neuronals artificials, l'oblit catastròfic es refereix a la dificultat d'ensenyar el sistema a realitzar noves habilitats sense perdre funcions prèviament apreses. Per exemple, si una xarxa inicialment entrenada per distingir entre fotografies de gossos i gats es torna a entrenar per distingir entre gossos i cavalls, perdrà la seva capacitat anterior.

Per contra, el cervell és capaç d'"aprendre contínuament", adquirir nous coneixements sense eliminar records antics, fins i tot quan s'utilitzen les mateixes neurones per a múltiples tasques. Una estratègia que utilitza el cervell per a aquest repte d'aprenentatge és l'activació selectiva de cel·les o components cel·lulars per a diferents tasques, essencialment activant subxarxes més petites i superposades per a cada habilitat individual o en diferents contexts.

Els investigadors d'UChicago van adaptar aquest mecanisme neuro-científic a les xarxes neuronals artificials a través d'un algoritme que ells anomenaven "alimentació dependent del context". Per a cada nova tasca apresa, només s'activa un 20 per cent aleatori d'una xarxa neuronal. Una vegada que la xarxa està capacitada en centenars de tasques diferents, un node pot estar involucrat en dotzenes d'operacions, però amb un conjunt únic d'operacions per a cada habilitat individual.

Els investigadors d'UChicago van adaptar aquest mecanisme neuro-científic a les xarxes neuronals artificials a través d'un algoritme que ells anomenaven "alimentació dependent del context". Per a cada nova tasca apresa, només s'activa un 20 per cent aleatori d'una xarxa neuronal. Una vegada que la xarxa està capacitada en centenars de tasques diferents, un node pot estar involucrat en dotzenes d'operacions, però amb un conjunt únic d'operacions per a cada habilitat individual.

Quan es va combinar amb mètodes desenvolupats prèviament per investigadors de Google i Stanford, les xarxes dependents del context van permetre a les xarxes aprendre fins a 500 tasques amb només una petita disminució de la precisió.

Com a tal, l'enfocament probablement té un gran potencial en la creixent indústria de l'AI, on les empreses que desenvolupen vehicles autònoms, la robòtica i altres tecnologies intel·ligents necessiten emprar capacitats complexes d'aprenentatge en ordinadors a nivell de consum. L'equip de UChicago treballa actualment amb el Polsky Center for Entrepreneurship and Innovation per explorar les opcions de comercialització de l'algoritme.

La investigació computacional també beneficia l'original focus del laboratori per comprendre millor el cervell primat recordant la seva activitat a mesura que els animals aprenen i com es comporten. Les estratègies de modelatge i assaig que permeten l'aprenentatge, l'atenció, el processament sensorial i altres funcions en una computadora poden motivar i suggerir nous experiments biològics que sonden els mecanismes d'intel·ligència, tant naturals com artificials.

Sumar en aquest component de la recerca al laboratori ha obert moltes portes en termes de permetre pensar en nous tipus de problemes, nous tipus de temes de neuro-ciència i problemes que normalment no es poden abordar utilitzant les tècniques experimentals actualment disponible als laboratoris. S'espera que aquest sigui el punt de partida per identificar aquests principis i per ajudar a crear xarxes artificials que continuen aprenent i basant-se en coneixements previs.

Sumar en aquest component de la recerca al laboratori ha obert moltes portes en termes de permetre pensar en nous tipus de problemes, nous tipus de temes de neuro-ciència i problemes que normalment no es poden abordar utilitzant les tècniques experimentals actualment disponible als laboratoris. S'espera que aquest sigui el punt de partida per identificar aquests principis i per ajudar a crear xarxes artificials que continuen aprenent i basant-se en coneixements previs.Font: Universitat de Chicago

.

Cap comentari:

Publica un comentari a l'entrada